电话:020-66888888

元科学家涵盖了变压器射线的纸张,十年前回顾

作者:bat365在线平台官网 发布时间:2025-05-03 14:19

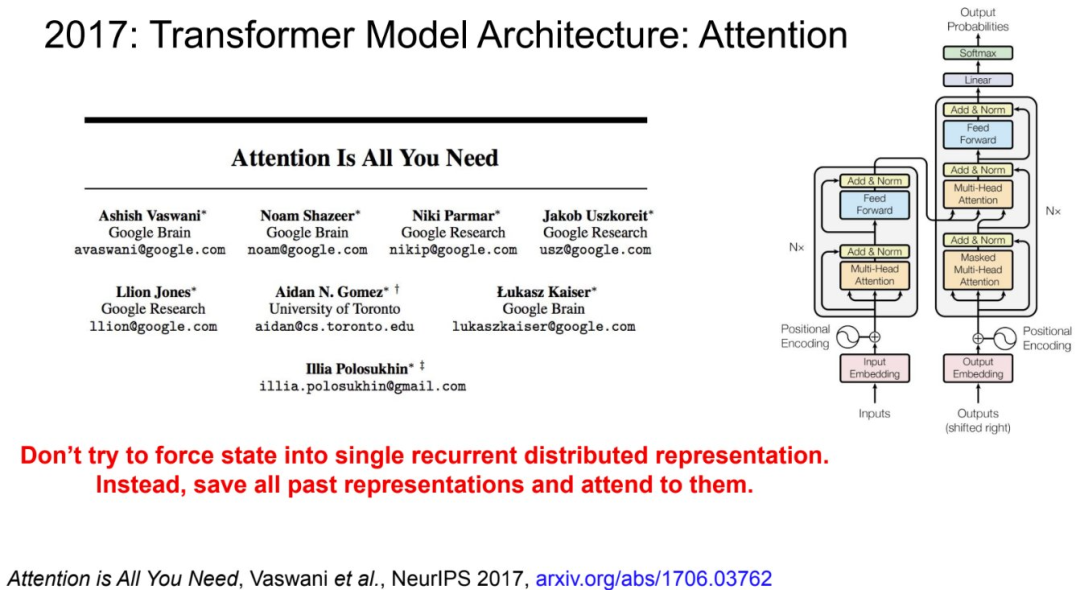

本文包含当前LLM的许多元素,十年后仍然值得一读。变压器角色是2017年出版的“关注就是您所需要的”,提到了超过170,000,这在AI技术革命的革命中一直是具有里程碑意义的角色。同时,它们涵盖了一些论文,例如2015年发布的“端到端记忆网络”。研究科学家Sainbayar Sukhbaatar在最近的推文中说:“反思,本文是键值预测,是键值的预测,堆叠了许多注意力,以使您的注意力不足,您的注意力不适合您所需的各个区域;引用。有一套角色是Facebook AI研究所“内存网络”的2014年角色的改进。 “内存网络”引入了一种困难的注意机制,多层将注意力集中在单层上。更多关注比那他说的是“您需要的全部关注”具有自己的独特之处。返回本文开头提到的“端到端内存网络”,实际上结合了“存储网络”和“通过联合研究的神经机器翻译的思想,以对齐和翻译”,并显示了多层软关注以产生复杂推理的能力 - 这是当今最重要的AI架构。除了主要变化外,第一本书Sainbayar Sukhbaatar还分享了本文诞生和他们正在进行的新作品背后的故事。一篇纸上纸变压器标题覆盖的论文:端到端的内存网络链接链接:https://arxiv.org/pdf/1503.08895sainbayar sukhbaatar https://arxiv.org/pdf/1503.08895sainbayar sukhbaatar https://arxiv.org/pdf/sainbayar sukhbaatar https://arxiv.org/pdf/1503.08895Sainbayar sukhbaatar回忆起他们的“端到端网络”回忆起2014年春季开始的。那时,他在他的第二年中曾在PhD中呆了第二年。他的顾问罗布·弗格斯(Rob Fergus)敦促他进行记忆研究。但是,当时他不明白记忆的含义,b因为它是一个以重复和卷积网络为主导的世界,而内存并不是当今的重要流行语。但是,他的研究不必从一开始就开始。从那时起,杰森·韦斯顿(Jason Weston)和Facebook AI研究所的其他人已经创建了一个“内存网络”。此外,他们发布了一组名为Babbi的任务,该任务毫不费力地失败了。因为这些任务需要以非生产力的方式找到许多事实,这是RNN的致命弱点。最初与“记忆”有关的项目吸引了很多关注,屁股情况进展不顺利。最终,他们着手进一步研究记忆网络,目的是让它知道专注于它们的位置,而无需给定标签。他们决定使用强化培训来教授记忆网络在哪里关注。快进到2014 - 2015年冬季,当时他们实施了强化研究守则,并准备比较机智H基准测试语言模型的工作。一个明确的选择是“通过共同研究以对齐和翻译来对齐和翻译”中使用的软注意机制 - 但是Sainbayar Sukhbaatar等人。它应用于其研究中的多层结构,但尚未完成。因此,他们将其作为基线实现,但进行了一些更改,例如在Halip中使用DOT产品,这是一个小型的多层感知器来计算注意力。令人惊讶的是,具有这种软关注的记忆网络令人震惊,他们意识到这是正确的方向。之后,事情开始迅速发展。随着强迫亚瑟·斯拉姆(Arthur Szlam)(另一组),团队开始使用BABI任务作为基准。他们创建了许多新技术,例如将不同的预测用于钥匙和值。他们还需要解决顺序注意的不变性,因此他们添加了时间 - 现在称为位置嵌入)。建议杰森在这些amo上添加随机噪声减少过度拟合。最后,他们决定执行当时不流行的语言建模任务。出人意料的是,他们只有任何时间都以注意力击败LSTM(在纸面上,他们使用“重复”一词来描述重复层,即共享权重,例如通用变压器)。他们在提交神经的最后一天写了大部分论文。值得注意的是,它最初被称为“弱化的内存网络”,因为它需要更少的管理。无论如何,那个时候是新建筑的黄金时代,新论文(如神经GPU,Stack RNN和Neural Turing机器)。 Sainbayar Sukhbaatar在10年后返回今天的大型语言模型的现状,并认为他们在角色中找到了一些要点。他们的模型是基于注意的第一语言模型,不依赖于复发。他们成功地堆叠着许多关注,允许在CONTEX的不同部分的模型中t在输出下一个令牌之前。他们还使用一个位置是一个位置,甚至是亲戚,现在已经成为大型语言模型的标准技能。尽管本文不会引起诸如“您需要的注意”之类的感觉,但它也有论文。有人说他们已经阅读了很多次,试图理解某种神经建筑的原因。 Sainbayar Sukhbaatar承认,变压器进行了重要的改进,例如使用上一层的隐藏状态作为下一层的内存。他认为,尽管过去十年来,但仍与改善建筑有很大关系。因此,几个小时前,他们发布了一个名为“ Multi-Token Guate”(MTA)的新帕普尔。 MTA控制着对许多查询,键和头部的关注,并且优于对多个指标的标准柔和关注。特别是,它可以更好地解决上下文问题,例如“在干草堆中找到针头”任务。值得注意的是,在2015年的“内存网络”纸的末期已经提到了它作为未来的工作:“在需要更多内存的情况下,平稳的查找可能无法很好地扩展”,这正是当今现场仍在研究的问题。

本文包含当前LLM的许多元素,十年后仍然值得一读。变压器角色是2017年出版的“关注就是您所需要的”,提到了超过170,000,这在AI技术革命的革命中一直是具有里程碑意义的角色。同时,它们涵盖了一些论文,例如2015年发布的“端到端记忆网络”。研究科学家Sainbayar Sukhbaatar在最近的推文中说:“反思,本文是键值预测,是键值的预测,堆叠了许多注意力,以使您的注意力不足,您的注意力不适合您所需的各个区域;引用。有一套角色是Facebook AI研究所“内存网络”的2014年角色的改进。 “内存网络”引入了一种困难的注意机制,多层将注意力集中在单层上。更多关注比那他说的是“您需要的全部关注”具有自己的独特之处。返回本文开头提到的“端到端内存网络”,实际上结合了“存储网络”和“通过联合研究的神经机器翻译的思想,以对齐和翻译”,并显示了多层软关注以产生复杂推理的能力 - 这是当今最重要的AI架构。除了主要变化外,第一本书Sainbayar Sukhbaatar还分享了本文诞生和他们正在进行的新作品背后的故事。一篇纸上纸变压器标题覆盖的论文:端到端的内存网络链接链接:https://arxiv.org/pdf/1503.08895sainbayar sukhbaatar https://arxiv.org/pdf/1503.08895sainbayar sukhbaatar https://arxiv.org/pdf/sainbayar sukhbaatar https://arxiv.org/pdf/1503.08895Sainbayar sukhbaatar回忆起他们的“端到端网络”回忆起2014年春季开始的。那时,他在他的第二年中曾在PhD中呆了第二年。他的顾问罗布·弗格斯(Rob Fergus)敦促他进行记忆研究。但是,当时他不明白记忆的含义,b因为它是一个以重复和卷积网络为主导的世界,而内存并不是当今的重要流行语。但是,他的研究不必从一开始就开始。从那时起,杰森·韦斯顿(Jason Weston)和Facebook AI研究所的其他人已经创建了一个“内存网络”。此外,他们发布了一组名为Babbi的任务,该任务毫不费力地失败了。因为这些任务需要以非生产力的方式找到许多事实,这是RNN的致命弱点。最初与“记忆”有关的项目吸引了很多关注,屁股情况进展不顺利。最终,他们着手进一步研究记忆网络,目的是让它知道专注于它们的位置,而无需给定标签。他们决定使用强化培训来教授记忆网络在哪里关注。快进到2014 - 2015年冬季,当时他们实施了强化研究守则,并准备比较机智H基准测试语言模型的工作。一个明确的选择是“通过共同研究以对齐和翻译来对齐和翻译”中使用的软注意机制 - 但是Sainbayar Sukhbaatar等人。它应用于其研究中的多层结构,但尚未完成。因此,他们将其作为基线实现,但进行了一些更改,例如在Halip中使用DOT产品,这是一个小型的多层感知器来计算注意力。令人惊讶的是,具有这种软关注的记忆网络令人震惊,他们意识到这是正确的方向。之后,事情开始迅速发展。随着强迫亚瑟·斯拉姆(Arthur Szlam)(另一组),团队开始使用BABI任务作为基准。他们创建了许多新技术,例如将不同的预测用于钥匙和值。他们还需要解决顺序注意的不变性,因此他们添加了时间 - 现在称为位置嵌入)。建议杰森在这些amo上添加随机噪声减少过度拟合。最后,他们决定执行当时不流行的语言建模任务。出人意料的是,他们只有任何时间都以注意力击败LSTM(在纸面上,他们使用“重复”一词来描述重复层,即共享权重,例如通用变压器)。他们在提交神经的最后一天写了大部分论文。值得注意的是,它最初被称为“弱化的内存网络”,因为它需要更少的管理。无论如何,那个时候是新建筑的黄金时代,新论文(如神经GPU,Stack RNN和Neural Turing机器)。 Sainbayar Sukhbaatar在10年后返回今天的大型语言模型的现状,并认为他们在角色中找到了一些要点。他们的模型是基于注意的第一语言模型,不依赖于复发。他们成功地堆叠着许多关注,允许在CONTEX的不同部分的模型中t在输出下一个令牌之前。他们还使用一个位置是一个位置,甚至是亲戚,现在已经成为大型语言模型的标准技能。尽管本文不会引起诸如“您需要的注意”之类的感觉,但它也有论文。有人说他们已经阅读了很多次,试图理解某种神经建筑的原因。 Sainbayar Sukhbaatar承认,变压器进行了重要的改进,例如使用上一层的隐藏状态作为下一层的内存。他认为,尽管过去十年来,但仍与改善建筑有很大关系。因此,几个小时前,他们发布了一个名为“ Multi-Token Guate”(MTA)的新帕普尔。 MTA控制着对许多查询,键和头部的关注,并且优于对多个指标的标准柔和关注。特别是,它可以更好地解决上下文问题,例如“在干草堆中找到针头”任务。值得注意的是,在2015年的“内存网络”纸的末期已经提到了它作为未来的工作:“在需要更多内存的情况下,平稳的查找可能无法很好地扩展”,这正是当今现场仍在研究的问题。